In diesem Webinar untersuchen Manoel Veiga und Kathy Lindsley, wie die Deep Learning Technologie genutzt werden kann, um komplexe Bildanalyseaufgaben zu bewältigen, z. B. eine effektive Zellerkennung in herausfordernden Hellfeldbildern und Zellklassifikationen, die für das menschliche Auge schwierig sind.

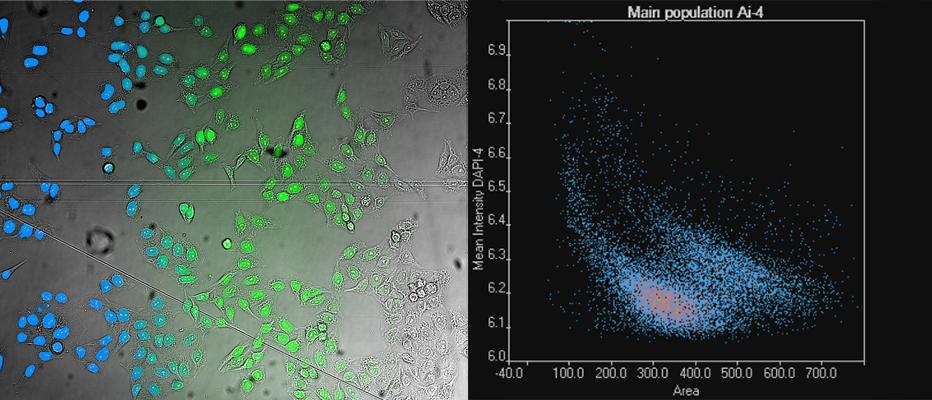

FAQHäufige Webinarfragen | Deep LearningKönnen nach der Anwendung von Deep-Learning-Algorithmen quantitative Helligkeitsmessungen durchgeführt werden?Mit Deep-Learning-Algorithmen lässt sich die Position eines Fluoreszenzsignals vorhersagen, nicht jedoch dessen Helligkeit. Man kann jedoch auf der Basis von Deep Learning eine Segmentierung vornehmen und dann den sekundären Kanal für eine quantitative Helligkeitsanalyse (z. B. der Fluoreszenz) verwenden. Wenn Sie z. B. die Expression eines Proteins bestimmen, ohne mit einem Marker zu arbeiten, und Ihre Probe mit sehr niedriger Energie bestrahlen möchten, können Sie die Segmentierung im Hellfeld-Bild durchführen und anschließend im sekundären Kanal die Fluoreszenz messen. Und wenn die Helligkeit niedrig, aber das Hintergrundsignal konstant ist, können Sie eine quantitative Analyse durchführen, selbst wenn das Signal nur wenige Impulse über dem Kamerarauschen liegt. Kann Deep-Learning-Software für (z. B. mit Hämatoxylin/Eosin) gefärbte histologische Schnitte verwendet werden?Ja, die cellSens Software enthält eine spezielle neuronale Netzarchitektur für RGB-Bilder. Dieses RGB-Netz bietet ein Augmentierungsverfahren, das die Anteile der verschiedenen Farben leicht verändert und damit sicherstellt, dass das neuronale Netz gegenüber leichten RGB- und Farbbalanceschwankungen unempfindlich ist. Wie viele Bilder sind zum Training der Deep-Learning-Software erforderlich?Der Schlüsselparameter ist weniger die Anzahl der Bilder als vielmehr die Anzahl annotierter Objekte. In einigen Fällen können 20 bis 30 Objekte ausreichend sein, allerdings kann das entsprechende neuronale Netz dann nur zur Analyse von Bildern mit ähnlichem Kontrast herangezogen werden. Wenn Sie außerdem ohne Marker arbeiten und Objekte unter schwierigen Bedingungen analysieren möchten, brauchen Sie in der Regel Tausende von Annotationen. Diese hohe Zahl von Annotationen kann z. B. durch die Anwendung von mit Fluoreszenzbildgebung automatisch erhobenen Daten des „Grundwissens“ erreicht werden. Stützen sich Olympus Deep-Learning-Algorithmen auf U-Net?Ja, sie sind an U-Net angelehnt. Sie sind zwar nicht identisch, aber ihre Gesamtstruktur basiert auf U-Net. Was ist der Unterschied zwischen tiefen und konvolutionalen neuronalen Netzen?Neuronale Netze haben eine Eingabe- und eine Ausgabeschicht. Ein tiefes neuronales Netz weist zwischen der Eingabe- und der Ausgabeschicht mindestens eine weitere und in der Regel mehrere Zwischenschichten auf. Konvolutionale neuronale Netze sind eine Klasse tiefer neuronaler Netze, bei denen die Zwischenschichten miteinander konvolviert („gefaltet“) sind. Konvolution ist eine mathematische Operation, die sehr gut zur Bildverarbeitung geeignet ist. Aus diesem Grund werden konvolutionale neuronale Netze zur Analyse von Mikroskopbildern verwendet. Deep Learning wird auch auf anderen Gebieten als der Bildanalyse eingesetzt. Diese Anwendungen erfordern keine konvolutionalen Netze, sondern nutzen andere Arten von Netzen." |